[罗戈导读]大家好,首先感谢主办方光博会和智东西给我提供一个机会与大家分享下,我们公司在移动机器人领域涉及到的3D视觉技术,本次演讲的主题为《3D视觉在室内移动机器⼈中的应用与展望》,主要分为以下5个部分

[罗戈导读]大家好,首先感谢主办方光博会和智东西给我提供一个机会与大家分享下,我们公司在移动机器人领域涉及到的3D视觉技术,本次演讲的主题为《3D视觉在室内移动机器⼈中的应用与展望》,主要分为以下5个部分

大家好,首先感谢主办方光博会和智东西给我提供一个机会与大家分享下,我们公司在移动机器人领域涉及到的3D视觉技术,本次演讲的主题为《3D视觉在室内移动机器⼈中的应用与展望》,主要分为以下5个部分:

1、使用场景

2、室内环境的特点

3、传感器

4、使用方式及问题

5、展望

炬星科技是一家比较年轻的公司,成立于2018年5月,同时也是一家基于室内移动机器人仓库自动化解决方案的提供商。上图是目前量产的机器人,传感器分布已经在上面标注出来,使用的是主动双目立体视觉传感器,这也是今天演讲围绕的传感器,为了保障机器人的可靠性,不仅使用主动双目传感器,还有超声传感器,由于光学传感器对玻璃没办法,主要靠超声,上图的机器人上也有超声传感器,下面还有一个单线激光雷达、里程计+IMU。

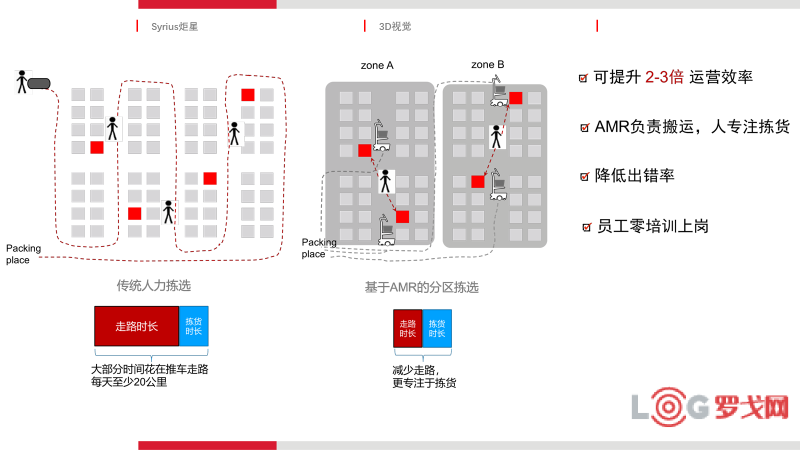

上图是一个典型应用,在现在的仓储物流尤其是电商仓库里,主要是通过人力拣选的方式,一个人拿到订单后到货架上把物品捡回来,最后打包,一个人一天最多可以走20公里,我们提供的解决方案是用机器人自动化的方式代替人行走,可以提高2-3倍效率,并且在应对仓库出货量波动方面具备高度的灵活性。

相较比于室外场景,室内大部分是结构化的场景,室内的东西都是人造的,但有时结构特征非常不清晰,比如长直走廊没有结构化特征。另外一个方面,我们所面对的仓库场景结构化特征重复的概率极大,在一排货架看到的结构场景与隔壁一排看到的场景几乎一样。所有的室内定位要么用UWB方案,要么用传感器感知,我们采取的是传感器感知,因为安装采用UWB的方案,部署成本太高。室内还会出现非常狭窄的情况,货架之间可能只有1米,造成机器人运动困难。对于光照,室内光照相对友好,但也会遇到一个问题就是强光,还有的仓库周围是玻璃,太阳光返到地面会造成视觉传感器过曝。

那为什么选择室内场景落地机器人技术?因为它的复杂度相对较低,可以被拿来真正产生社会价值,而像比较流行的自动驾驶,未来技术路线还有一段时间,没法马上产生价值。

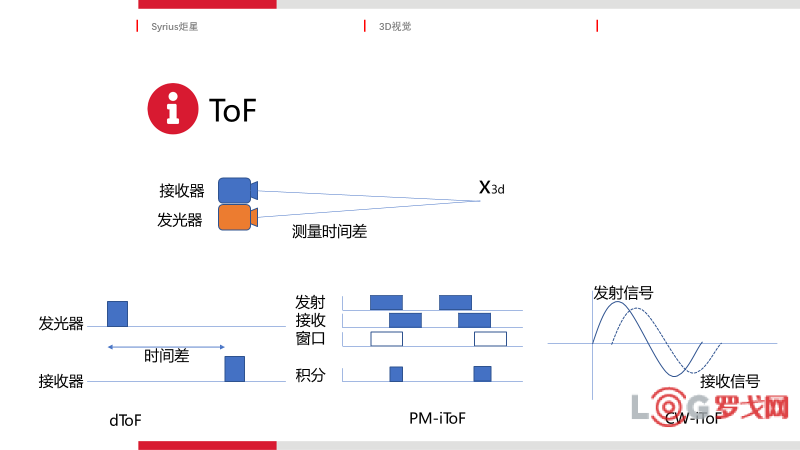

下面简单介绍下3D视觉传感器的主流方案,总结了六种方案:双目、结构光、主动双目、dToF、PM-iToF、CW-iToF,实际可能会更多一些。上图左边的三个方案基于三角法,右边是三个方案基于TOF。

上图是总结的基于三角测距的原理,下面介绍下主动双目的特点,主动双目相较于双目相机的第一个优势是有一个IR发射器,第二个优势在于发出的是结构光,室内有很多白墙,可以同样进行双目匹配,而这个点在双目相机是没有的。

接下来看下ToF,ToF总结了三种,第一种是dToF,它的难点在于,假设测量距离是3米,时间差是纳秒级的,芯片非常难造,在激光雷达方面,像车载的激光雷达、旋转式激光雷达也是基于dTOF,中间是PM-iToF是间接ToF方法,接收器接收两个脉冲,有两个积分窗口,我们可以积分出两个信号出来,通过这两个信号的比值计算时间。CW-iTOF是通过发射信号和接收信号的相位差计算飞行时间。

双目在室外比较主流,室内暗的地方比较难解决,而且没有纹理的地方解决不了,双目结构光是中等距离,它的测距在5-8米。i-ToF是中短距离,国内厂商做i-TOF比较多,都有自己的一套解决方案,d-ToF做得相对少一些,它存在近距离的精度问题,因为距离越近,测量越难。

炬星选择的视觉方案是主动双目光,除了主动双目光,我们还在模组上加了全局快门鱼眼相机和IMU,鱼眼相机的角度非常大,拍的特征非常全,全局快门没有滚动快门的缺点,我们选择这款相机主要是为了支持我们的应用,一个是语义导航,一个是更准帮助定位。

下面介绍下传统的3D感知怎么用于避障。首先拿到一个深度图,3D是可以直接输出的,有的3D相机也有直接输出点云的,上图第二张图片可以看到这块是一个地面,和地面上的障碍物。先进行地面检测,把地面和障碍物分开,把障碍物投影到当前地图上,路径规划就会绕开这个障碍物,这是所有厂商都在用的方式,但是和我们现在用的方式稍微有点区别。

我们做的是基于深度学习的语义导航,把图片识别和深度相机结合起来,在一个图像上识别到一个人,深度图上知道这个人的位置,我画在这上面时知道是一个人,当它是一个静态障碍物时,我知道它是一个箱子。

上图是一个静态障碍物时机器人的行为,如果是静态障碍物,机器人离这个箱子不到10公分避障,如果是一个人,机器人稍微等一下,因为对于人来说,人是运动的,机器人可以绕过它,但是离得太近,人一动机器人可能来不及反映,为了保障安全,我们需要知道前面看到的障碍物是人还是静态的障碍物。

3D相机第二个应用是利用3D相机进行更精确的机器人状态估计,就是把3D信息融合到视觉SLAM里。先介绍下视觉SLAM的几种方案,视觉SLAM一般在工业机器人都加入了IMU。由于双目相机市面上大部分是大广角的,鱼眼相机能计算的特征深度准确性相对差一些,这几个原因都会导致一个问题,在现有的视觉方案中,对于一个特征点的3D坐标估计要么是不准,要么是估计不出来,对3D坐标估计恰恰是视觉SLAM的核心要素,因为它都是靠误差来构造它的优化函数,我们“有机会”地把3D信息融合进去,在有3D信息时,直接拿3D信息构建残差。因为3D信息非常有限,3D传感器的角度不是鱼眼,而且高精度的距离只有5米,“有机会”地拿这个信息进行融合,就可以解决上述的问题。

第一个大方向是如何获取3D信息?传感器未来会往哪里走?现在的三角法测距瓶颈在于机械,基线越大,距离越远,对于80公分宽的机器人,基线越大,模组的标定越困难,据我了解三角法的工艺已经到了极限,再往大会非常困难,i-ToF是现在很多厂商的发力重点,未来我认为d-ToF是厂商的发力重点。

第二个方向是基于深度学习的3D生成也是未来的方向,上面的文章总结2014-2019年所有用视觉生成3D信息的方法,不用特别高精的传感器,只用相机生成一个3D信息,它生成3D信息可能不那么准,如果要做一些非常简单的识别和避免碰撞,这个还是可以满足的。

第三个方向是基于多传感器融合的3D生成,这篇文章比较有意思,它把一个16线的激光雷达和单目相机融合生成全景的3D图,16线激光雷达只有16线,一个全景图有几百条线,在几百条线上做感知的应用比16个线简单得多。

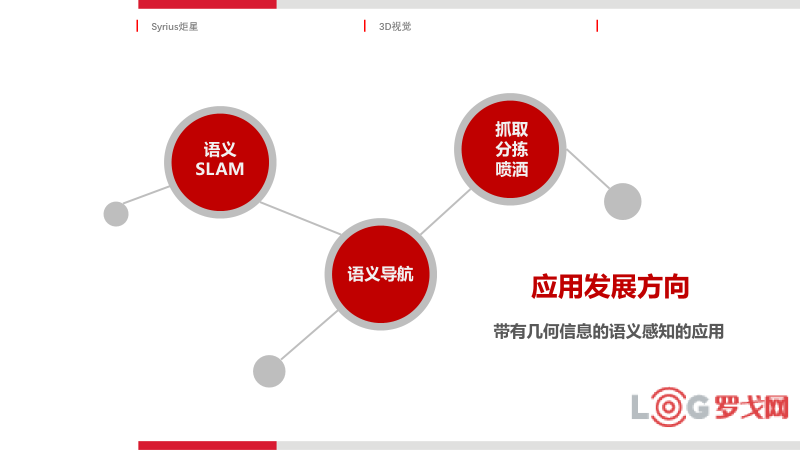

对于应用来说,它的落脚点在哪里?我认为带有几何信息的语义感知的应用,3D传感器同时能给到语义信息以及对应的几何信息,首先它支持更高精的定位,语义SLAM是现在研究界大的发展方向,语义信息可以在前端匹配,后端优化,以及回环检测等。语义导航根据不同的情况采取不同的导航策略实现不同的功能,带有几何的语义感知应用还有哪些?刚才看到的抓取、分拣,疫情期间有很多机器人在医院里面喷洒药物,我知道哪里人聚集得多,哪里人聚集得少,可以更精确喷洒药物。比如扫地机器人,知道前面是一个地毯,可以更精准的打扫等,这一系列的应用都是基于几何信息和语义信息的结合,我认为这是未来3D传感器的发展方向。

今天的演讲就到这里,谢谢!

UPS卖掉货运后,FedEx也考虑剥离货运,全球公路货运寒冬?

5149 阅读

41页PPT深度解读京东物流一体化供应链模式!

1769 阅读

杨兴运带队,兴满城市合伙人走进满帮!

1110 阅读京东发布自研无人轻卡,注册无人物流商标?刘强东深入汽车圈了?菜鸟、顺丰、京东无人物流车哪家强?

1002 阅读物流“客服”的蜕变:从“客户服务经理”走向“客户成功经理”

1019 阅读中国船舶吸收合并中国重工获上交所并购重组审核委员会审核通过

958 阅读全国首个海铁联运专用铁路场站投运

1000 阅读刚刚,极智嘉上市!一图速览IPO亮点

996 阅读仓储自营还是外包?

890 阅读成本大降,无人快递车价格从百万元“杀”到1万多元!业内专家:仍在爆发前夜

870 阅读